얼른 개발자 세계에 던져지고 싶어서 지원한 ICT 인턴십...!

전공 12학점에 월급도 받을 수 있어서 정규학기도, 인턴생활도 하고 싶었던 나에게 꼭 필요한 프로그램이었다.

일반적으로 인턴 전형이 진행되는 기간을 생가하면 약 한달간 최대 세군데 회사에 지원할 수 있다는 점도 큰 장점인 것 같다.

지원 과정은 다음과 같다.

1. 7/5 - 7/14: 희망기업 서류 지원

2. 7/14 - 7/15: 코딩테스트 실시

3. 7/15 - 7/26: 기업별 서류 발표 및 면접 진행

4. 7/27 - 7/28: 인턴기업 확정 처리

(원래는 서류 지원이 13일까지였는데 마지막날 지원자가 모여서 서버가 마비되었는지 서류지원 마감날이랑 코딩테스트 시작 날짜가 14일로 하루씩 밀렸다.)

약 140여개 회사 중 아래 기준으로 지원하고 싶은 회사를 골랐다.

1. 내가 원하는 기술스택을 사용하는 회사인가?

2. 회사에서 만드는 서비스가 흥미롭게 느껴지는가?

3. 대중교통으로 90분 이내에 갈 수 있는가?

나는 수요가 많다는 이유로 스프링 공부를 해왔기 때문에 실무에서 스프링을 사용하는 이유를 직접 겪으며 이해하고 싶었다. 또한 내가 흥미를 가질만한 주제여야 4개월동안 열정을 갖고 즐겁게 참여할 수 있을거라고 생각했다.

그리고 복지(식대, 간식지원)가 많은 회사에 마음이 가버릴까봐 그 부분은 일부러 자세히 읽지 않았다... !

1번, 3번 기준을 만족하는 회사를 리스트업하니 8개 회사가 남았다. 회사가 어떤 서비스를 제공하는지는 회사 홈페이지와 회사 소개 파일에서 찾아봤고 2번 기준으로 3개 회사를 골랐다.

이력서, 자기소개서, 포트폴리오 총 3개 서류를 준비했다.

세 서류 모두 자체 양식을 만들었다. 포트폴리오는 선택사항이긴 하지만 내가 어떤 프로젝트를 했는지 잘 보여줄 수 있을 듯해 따로 만들었다. 셋 다 처음 작성해봐서 요령도 시간도 없었지만 주변 사람들의 도움으로 잘 마무리할 수 있었다. 나는 어떤 구성으로 써야할지 정말 막막했어서 부족하지만 조금이나마 도움이 되길 바라며 글을 남긴다..!

서류를 준비할 때 크게 두가지를 지키려 했다.

1. 쉽게 읽을 수 있는 서류를 만들자. (형식과 내용 모두)

이 서류만 슬쩍 보고도 내가 어떤 사람인지 감이 오게끔, 친절하고 쉽게 작성하는 것을 목표로 삼았다. 어떤 도메인을 가진 사람이든 이해할 수 있을만한 단어를 사용하고 문장구조를 단순하게 만들었다. 줄간격과 줄바꿈, 여백 배치, 폰트를 조절하며 보기 좋은 서류를 만들려고 했다.

2. 채용하는 사람이 궁금할만한 정보를 넣자.

목표는 이렇게 잡았지만 채용담당자가 무엇을 궁금해할지 잘 모르겠더라... 특히 ict 인턴십은 각 회사별로 지원자에게 궁금해하는게 다를 수도 있겠다는 생각이 들었다. 그래서 그냥 구글링으로 이력서 양식과 자기소개서 질문 항목, 포트폴리오 예시를 찾아보며 최대한 일반적인 양식을 만들려고 노력했다. 아래는 내가 작성한 서류 양식이다.

- 이력서

- 개인정보(이름, 생년월일, 전화번호, 이메일, 전공 및 전체평점, 주소)

- 학력 및 경력사항

- 수상내역 및 출판

- 보유기술

- 어학능력

- 프로젝트 경험 요약

- 자기소개서

- 지원동기

- 내가 지닌 강점

- 입사 후(혹은 개발자로서의) 포부

- 포트폴리오

- 사용할 수 있는 스킬 요약

- 대표 프로젝트 3개

- 프로젝트 소개

- 담당 역할

- 느낀점

- 내 성장에 영향을 준 경험 2개(동아리, 연구실)

- 무엇을 했는가

- 무엇을 얻었는가

해커랭크에서 코딩 테스트를 봤다.

내가 지원한 회사 중 두 곳은 코딩 테스트를 봤다. 해커랭크에서 12시간동안 5문제를 풀도록 안내받았고 sample test도 있어서 크게 적응이 어렵진 않다. sample case 결과를 보여준다는 점에서 백준보다는 프로그래머스와 유사한 플랫폼이라고 느꼈다. 난이도는 백준 실버4부터 골드5까지 골고루 나오는 것 같다. 코딩테스트 기간이 끝난 후 이틀 내로 결과 리포트가 메일로 왔다. 모범답안도 함께 오니까 참고해서 자신의 코드를 분석해봐도 좋을 것 같다.

운좋게도 세 곳에서 모두 면접을 볼 수 있었다.

면접준비만으로도 이론공부를 빡세게 할 수 있다고 생각해서 붙을 수 있을지 걱정하기보다 그냥 공부하는 마음으로 준비했다. 평소에 기초가 부족했는지 알아야 하는게 많더라..ㅎㅎ 이력서와 자기소개서, 포트폴리오를 보고 예상 질문을 작성하고 자바/스프링 면접 단골질문 리스트를 추가했다. 질문과 답변을 모두 적으니 8장정도 나왔던 것 같다. 세 회사 공통적으로 프로젝트를 진행할 때 갈등상황이 있었는지, 갈등을 어떻게 해결했는지와 이 회사에 지원하게 된 동기를 물었다.

- A회사에서는 프로젝트에서 사용한 기술 위주로 왜 그렇게 했는지에 대한 질문을 많이 받았다. 일대일 대면으로 약 40분간 진행했다.

- B회사에서는 단순 반복문부터 자바, 스프링, 데이터베이스 등 기술 질문과 팀 프로젝트 관련 질문도 받았다. 일대일 비대면으로 약 30분간 진행했다.

- C회사는 내가 한 경험 위주로 질문하셨고 느낀점을 답하면 되어서 가장 편안했다. 일대일 대면으로 약 40분간 진행했다.

A, C 회사에서 면접합격 소식을 들었다.

나는 서류를 넣을 때 1순위, 2순위, 3순위 회사가 없었다. 두가지 이유가 있는데 첫번째 이유는 회사 순위를 매기는 기준에 따라서 순위가 계속 바뀌었고 무엇이 제일 나은 기준인지 헷갈렸기 때문이다. 두번째 이유는 1순위 회사를 정했는데 떨어지면 아쉬움이 더욱 클 것 같아서였다. 선택을 해야만하는 때가 와서 주변에 조언을 구했고 다들 우문에 핵심을 꿰뚫는 답변을 해주셨다. 일이 조금 힘들더라도 네가 가장 성장할 수 있을 것 같은 곳으로 가는 것이 좋다는 것이다. 이 이야기를 듣고 어느 회사를 가는게 좋을지 명료해졌고, 26일에서 27일 넘어가는 자정이 되자마자 바로 A회사 인턴확정 버튼을 눌렀다!

마음은 후련하지만 새로 고민할 거리가 생겼다!

약 1년간 내 단기적인 목표는 인턴을 하는 것 그 자체였다. ict 인턴십에 지원하며 좋은 기회를 얻었고, 이제는 어떻게하면 4개월을 잘 보낼 수 있을지 고민해봐야겠다. 우선은 주기적으로 배운 것과 느낀 점을 쓰려 한다. 매일 한걸음 더 나아가는 사람이 되어야겠다!

'etc' 카테고리의 다른 글

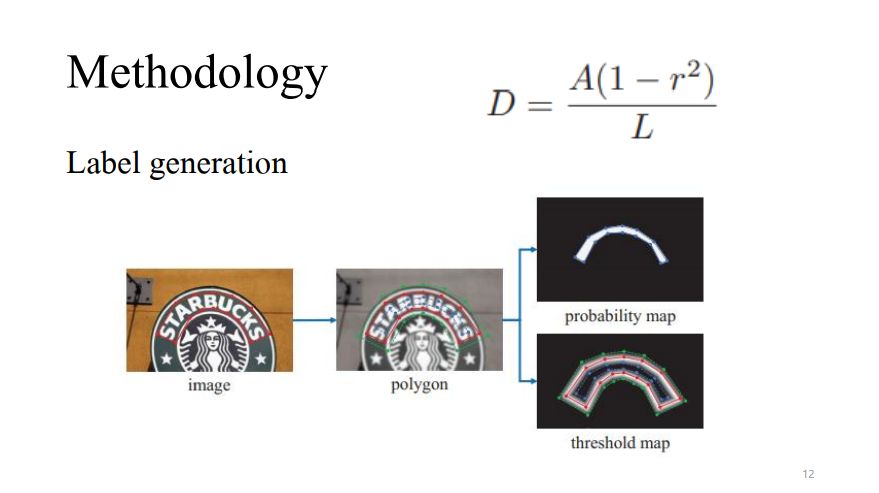

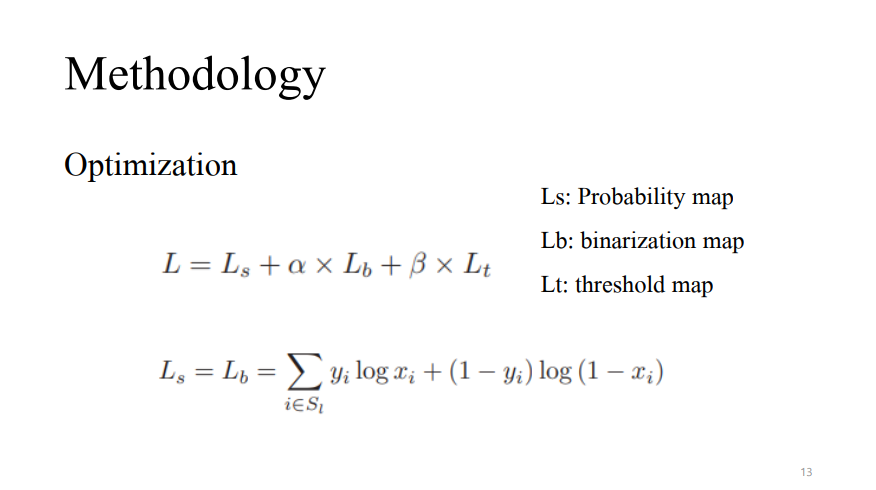

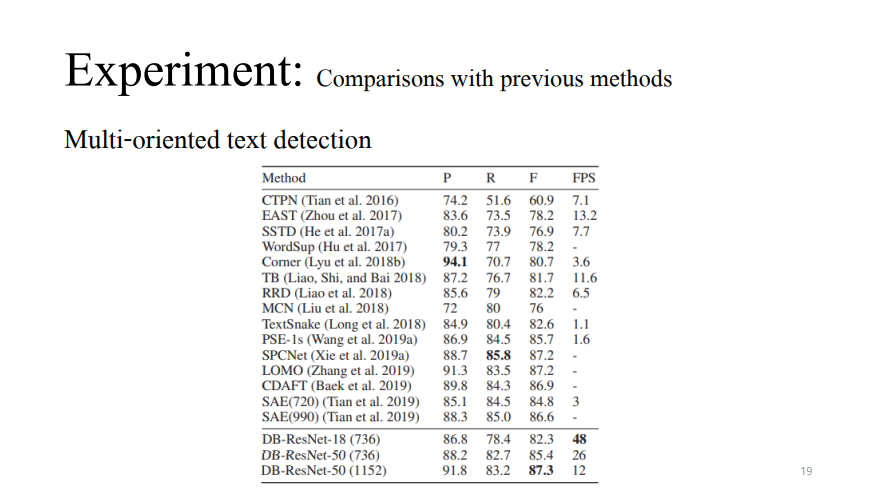

| [Paper Review] Real-Time Scene Text Detection with Differentiable Binarization (0) | 2021.05.12 |

|---|